Jan - transformer son ordinateur en machine intelligente.

Si vous avez lu l'article sur Ollama, Jan est son équivalent plus graphique avec une interface utilisateur accessible et épurée. Jan permet d'utiliser des LLMs (des I.A. conversationnelles). C'est gratuit, open source et c'est disponible sur Linux, Windows et macOS.

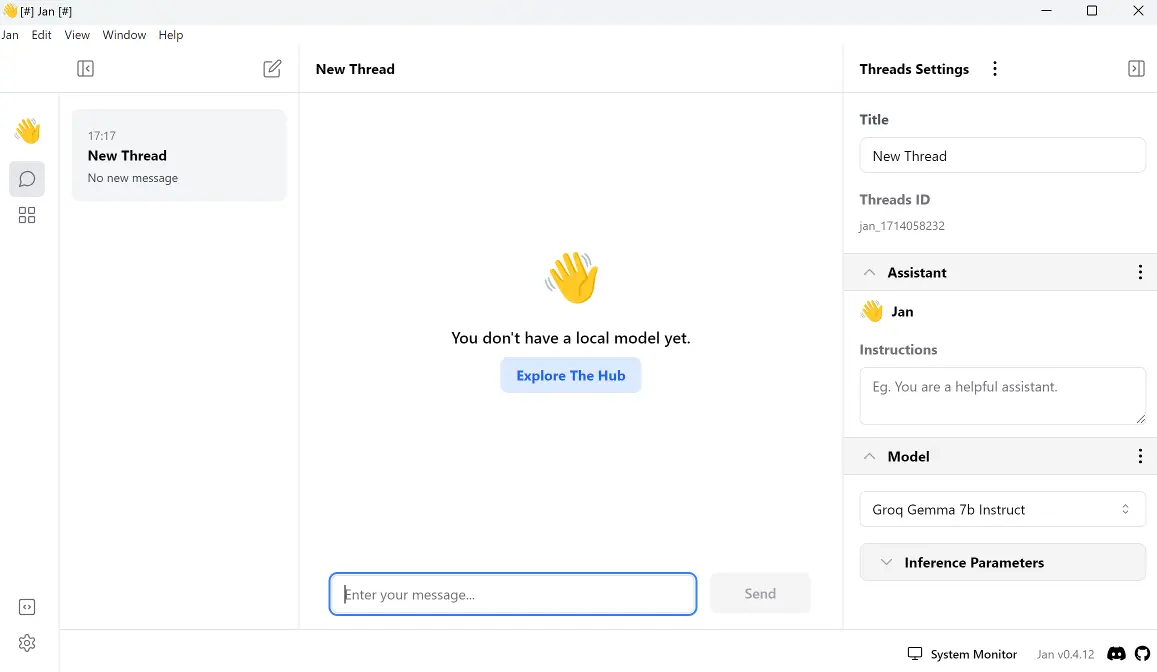

Lorsque vous lancez Jan pour la première fois, vous avez un message "You don't have a local model yet". Cliquez sur le bouton "Explore The Hub" pour avoir accès à une présélection de 42 modèles. Mais vous n'êtes pas limité à ce nombre, sur le site web de Jan, repérez le bouton "Hugging Face 71 models" et cliquez dessus. Cliquez sur le modèle qui vous intéresse. Repérez l'icône à droite du titre et cliquez dessus pour copier l'adresse du modèle et collez l'adresse dans la zone "Search or paste Hugging Face URL". Ensuite, il suffit de cliquez sur le bouton "Download" en face de la version du modèle qui vous intéresse. Une fois le téléchargement effectué, cliquez sur "Use".

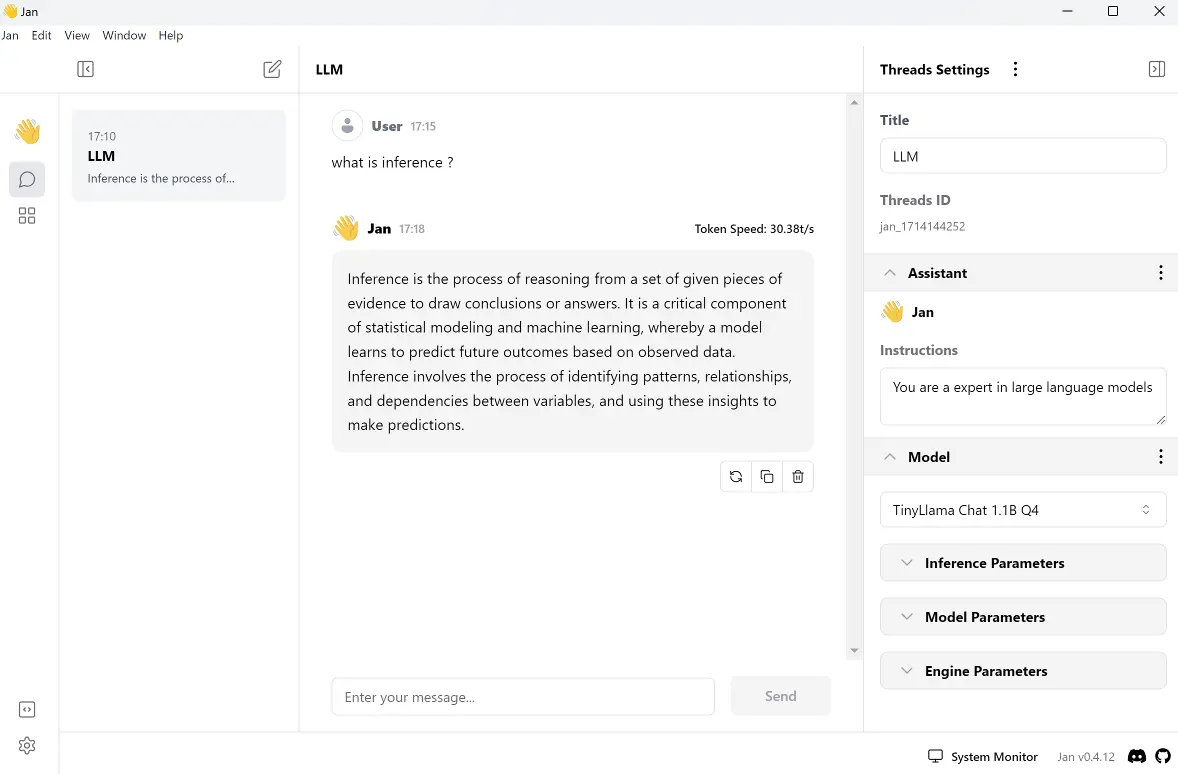

Une fois le modèle chargé, vous pouvez indiquer (à droite de l'interface - Threads settings) un titre à votre discution (Title) pour la retrouver plus facilement par la suite. Donner une instruction au modèle pour qu'il se comporte d'une certaine façon (Instructions). Le nom du modèle utilisé est affiché sous "Model". Ensuite, vous avez 3 types de paramètres : les paramètres d'inférence, les paramètres du modèle et les paramètres moteur.

- Les paramètres d'inférence (Inference Parameters) :

- Temperature : détermine si la réponse est plus aléatoire et créative ou plus prévisible. Une température plus élevée entraînera une probabilité plus faible, c'est-à-dire des résultats plus créatifs.

- Top P : une valeur plus faible permet d'obtenir une réponse plus précise à une requête concrète. Une valeur plus élevée permet une réponse plus créative à une requête plus libre.

- Stream : permet de traiter la requête en temps réel.

- Max Tokens : permet de limiter la taille de la réponse. Une valeur élevée permet une réponse plus complète et une valeur plus faible une réponse plus concise.

- Stop : permet de renseigner un mot ou une phrase pour signaler au modèle de stopper la génération de la réponse.

- Freqency Penalty : en augmentant la valeur, oblige le modèle à se répéter un peu moins pour une écriture plus créative orientée contenu.

- Presence Penalty : en augmentant la valeur, encourage le modèle à usiter de concepts nouveaux et variés pour une production plus diversifiée.

- Les paramètres du modèle (Model Parameters) :

- Prompt template : permet de structurer la réponse du modèle.

- Les paramètres du moteur (Engine Parameters) :

- Context Length : permet d'adapter la taille de la requête. Ce paramètre dépend du modèle sélectionné.

- Number of GPU layers (ngl) : plus la valeur est élevée plus le nombre de couches neuronales du modèle est supporté par le GPU.

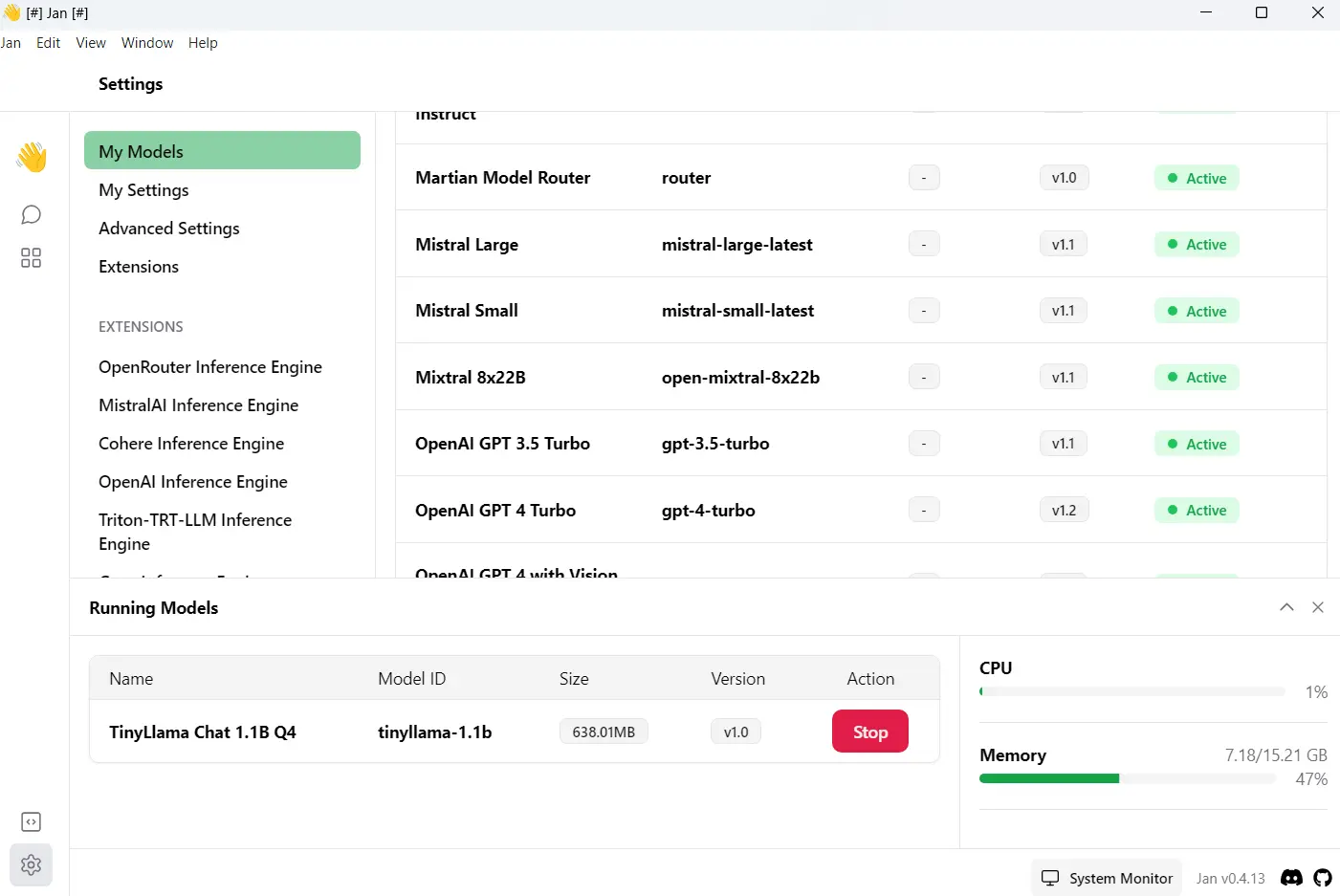

En bas de l'interface, à droite, en cliquant sur "System Monitor" (Moniteur Système), vous pouvez vérifier la charge au niveau du processeur (CPU) et de la mémoire vive (Memory) et stopper le modèle avec le bouton rouge (Stop). À gauche, vous avez l'icône des paramètres (Settings) qui vous permet dans "My Models" (Mes modèles) de gérer vos modèles téléchargés, de (re)démarrer le modèle sélectionné (Start Model) et de le supprimer (Delete Model). Dans "My Settings" (Mes réglages) vous pouvez modifier l'apparence de l'interface et visualiser les raccourcis clavier. "Advanced settings" (Réglages avancés) donne accès à des réglages plus poussés comme par exemple l'utilisation du GPU, la possibilité de vider le cache de l'application (Clear Logs) et de remettre l'application dans son état initial (Reset To Factory Default). Dans "Extensions", vous pouvez paramètrer celles-ci pour les utiliser dans l'application. Voilà ce qui conclut la présentation de Jan !

En résumé :

À l'instar d'Ollama, Jan permet d'installer localement et facilement des modèles d'I.A. conversationnelles. Disponible sur Linux, Windows et macOS. C'est gratuit et open source. Jan est plus simple à prendre en main qu'Ollama.